随着ChatGPT的炒作,大多数人对人工智能的前景感到兴奋,但他们忽视了其陷阱。如果我们想拥有真正理解其环境、持续学习并每天帮助我们的智能机器,我们需要将神经科学应用于深度学习AI模型。然而,除了少数例外,这两个学科在几十年间一直保持惊人的孤立。

这并不总是这样的情况。在1930年代,Donald Hebb和其他人提出了关于神经元如何学习的理论,这激发了第一个深度学习模型。然后在1950年代和60年代,David Hubel和Torsten Wiesel因理解大脑的感知系统如何工作而获得了诺贝尔奖。这对今天的AI深度学习中的卷积神经网络产生了很大的影响。

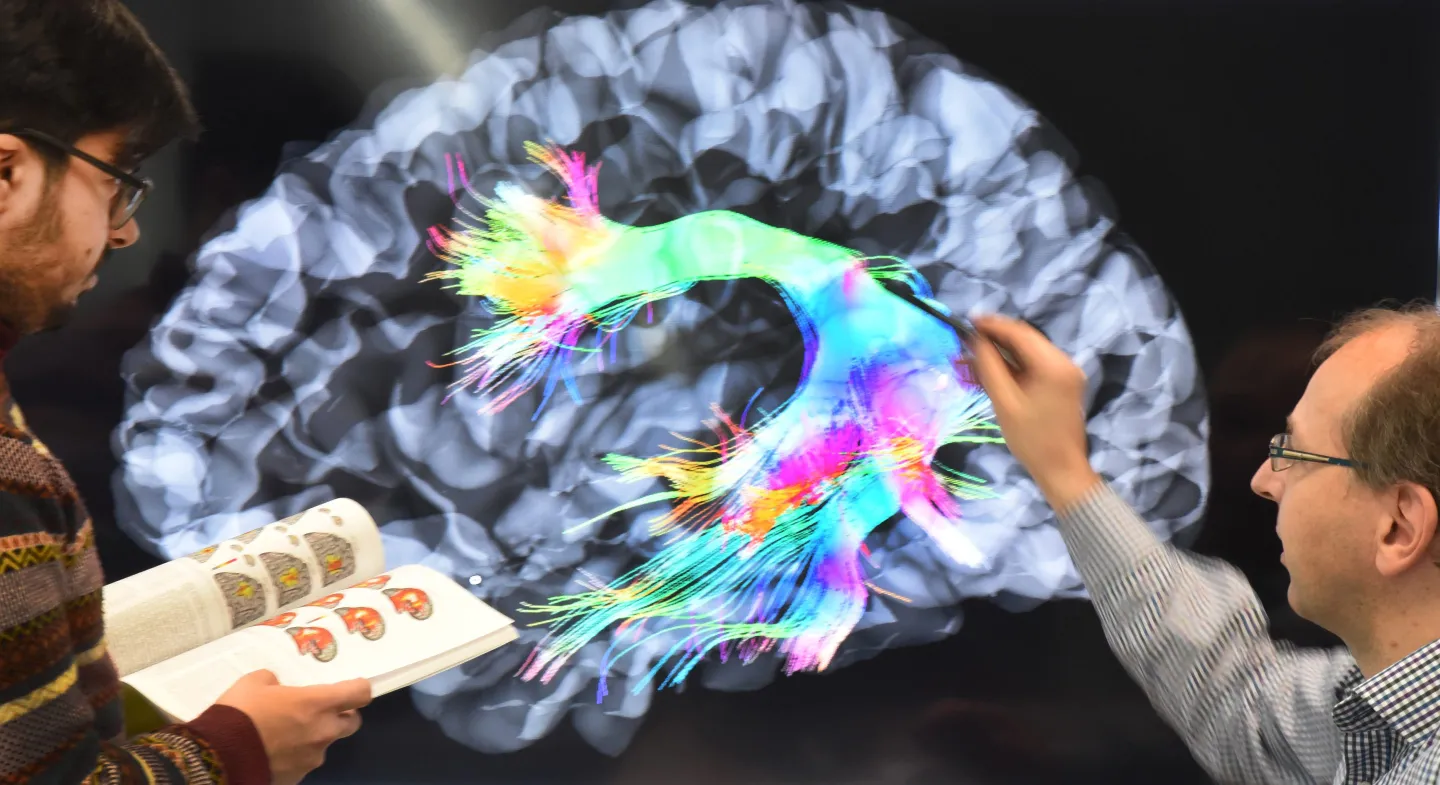

大脑的超能力 尽管神经科学作为一个领域在过去的20到30年中爆炸式地增长,但几乎没有这些更近期的突破在今天的AI系统中得到体现。如果你今天问一般的AI专家,他们对这些进展一无所知,也不明白最近的神经科学突破如何对AI产生影响。如果我们想要能够推动科学和知识边界的AI系统,这种情况必须改变。

例如,我们现在知道我们的大脑中有一个常见的电路,可以用作AI的模板。 一个成年人的大脑消耗大约20瓦的功率,或者说不到一个灯泡的一半。今年1月,ChatGPT消耗的电力大约相当于175,000人。鉴于ChatGPT的迅猛增长,它现在每月消耗的电力相当于1,000,000人。马萨诸塞大学阿姆斯特丹分校的一篇论文指出,“训练一个AI模型可能会排放出与五辆汽车在其一生中排放的碳一样多。”然而,这种分析只针对一个训练运行。当模型通过重复训练得到改进时,能源使用量大大增加。

除了能源消耗外,自2012年以来,训练这些AI系统所需的计算资源每3.4个月翻一番。今天,随着AI使用的惊人增长,估计推理成本(和功率使用)至少比训练成本高出10倍。这完全是不可持续的。

大脑不仅仅使用大型AI模型使用的能源的一小部分,而且它也是“真正”的智能。与AI系统不同,大脑可以理解其环境的结构,进行复杂的预测并执行智能操作。与AI模型不同,人类持续并逐步学习。相反,代码还没有真正地“学习”。如果一个AI模型今天犯了一个错误,那么它将继续重复那个错误,直到使用新数据重新训练。

神经科学如何提高AI性能 尽管对跨学科合作的需求日益加剧,但神经科学家和AI从业者之间的文化差异使得沟通变得困难。在神经科学中,实验需要大量的细节,每一项发现可能需要两到三年的仔细记录、测量和分析。当研究论文被发表时,细节通常对AI专家和计算机科学家来说是难以理解的。

我们如何弥合这个差距?首先,神经科学家需要退后一步,从大局的角度解释他们的概念,这样他们的发现才能对AI专家有意义。其次,我们需要更多的具有混合AI-神经科学角色的研究者来帮助填补这两个领域之间的差距。通过跨学科合作,AI研究者可以更好地理解神经科学发现如何被翻译成受大脑启发的AI。

最近的突破证明,将基于大脑的原则应用于大型语言模型可以提高效率和可持续性,数量级地增加。在实践中,这意味着将基于神经科学的逻辑映射到运行AI模型的算法、数据结构和架构,使其可以像我们的大脑一样在非常少的训练数据上快速学习。

几个组织正在取得进展,将基于大脑的原则应用于AI,包括政府机构、学术研究者、Intel、Google DeepMind和像Cortical.io这样的小公司(Cortical使用Numenta的技术,Numenta在Cortical中拥有一部分作为我们的许可协议的一部分)。这项工作对于我们扩大AI努力,同时保护气候至关重要,因为今天的深度学习系统正在朝着更大的模型迈进。

从天花疫苗到灯泡,几乎所有人类最伟大的突破都来自多个贡献和跨学科合作。这也必须发生在AI和神经科学之间。

我们需要一个未来,AI系统能够真正与科学家互动,帮助他们创建和运行实验,推动人类知识的边界。我们需要真正增强人类能力的AI系统,与我们所有人一起学习,并在我们生活的各个方面帮助我们。

无论我们喜欢与否,AI都在这里。我们必须通过弥合神经科学-AI的差距,使其变得可持续和高效。只有这样,我们才能将正确的跨学科研究和商业化、教育、政策和实践应用于AI,使其可以用来改善人类的状况。

原文链接:点击这里